2025 證券下單前風控檢核:LangGraph vs Semantic Kernel vs AutoGen 低後悔選擇(Set)

清單類型: low-regret-starter

前提

排除

TL;DR(3 句內,先下結論)

1) 要把下單前檢核流程「寫成可稽核的工作流」:先從 LangGraph 開始。

2) 要站穩企業治理接入點(身份/權限/交付/平台):先看 Semantic Kernel,再把 AutoGen 當成 multi-agent 的工程層。

3) 如果你要的是全自動交易代理(不是交易輔助 + 人審):別用 LangGraph/Semantic Kernel/AutoGen 來合理化黑箱決策,這篇不適合。

做對外下單前檢核、人審與內控稽核?我的建議是:先用 LangGraph 或 Semantic Kernel + AutoGen 把流程釘死;如果你要做全自動交易代理,這篇不適合。

先把話講清楚:你要做的是「下單前檢核流水線」,不是「自動交易代理」

我先假設你跟我一樣討厭兩種結局:

- 上線後客訴/爭議出現,你只能說「當時模型就這樣回」

- 稽核來了,你翻不出「當時的輸入快照 / 規則版本 / 誰批准」

所以本文把前提鎖死在這三件事:

- 對外服務(客戶會依你系統輸出行動)

- 任何 AI 輸出最終必須人類審核(Human‑in‑the‑loop)

- 內控稽核要過(事後能重放、能追責、能交代版本與依據)

在這個前提下,選 multi‑agent 框架的唯一核心標準是:

能不能把「每一次下單前檢核」變成可稽核的流程紀錄(而不是一段不可重現的對話)。

Premise(本文前提)— 沒有這些,就不適用

- 你要解的問題:把下單前的風控/倉位/限制檢核,從「人腦 + Excel + 經驗」變成「一致、可重放、可追責的流程」。

- 你接受的系統定位:AI 只能提出檢核建議與證據整理,最後按下批准的人才是責任 owner。

- 你的工程策略:硬規則優先 deterministic;LLM 只負責「解讀、摘要、比對、說明」,不做越權裁決。

- 你的現實:混合技術棧,多團隊交接與維運要可行。

Exclusions(本文排除)— 你如果是這種情況,請不要照做

- 你要做的是自動下單 / 自動交易決策:你要的是交易代理而不是交易輔助;本文會刻意把你卡死(因為「可稽核 + 人審」是硬門檻)。

- 你做不到內控稽核的基本功:你無法完整留存事件、版本、快照、批准紀錄;出事時你只能靠回憶。

- 你想靠 multi‑agent 解決組織問題:批准權責不清、停損線不存在、變更流程沒人管——多代理只會把混亂放大。

Decision rules(這篇文章用來下結論的規則)

- 如果你的核心是「流程可稽核」 → 優先選能把 workflow 寫成明確結構、可保存狀態與事件的框架(例如 LangGraph)。

- 如果你最痛的是「企業整合與治理接入點」(權限、審計、平台、C#/.NET 交付)→ 優先選 Microsoft 生態的框架(Semantic Kernel / AutoGen)。

- 如果你還沒把 deterministic 檢核做起來 → 任何「先做多代理」都算走錯順序;先把規則引擎與稽核包定義好。

- 如果你無法定義 kill switch 與降級路徑 → 不要上 LLM 解釋層;先上規則直出與人工審核流程。

- 如果一個框架讓你只能存「對話文字」 → 在金融稽核情境視為高風險,除非你願意外掛完整治理殼。

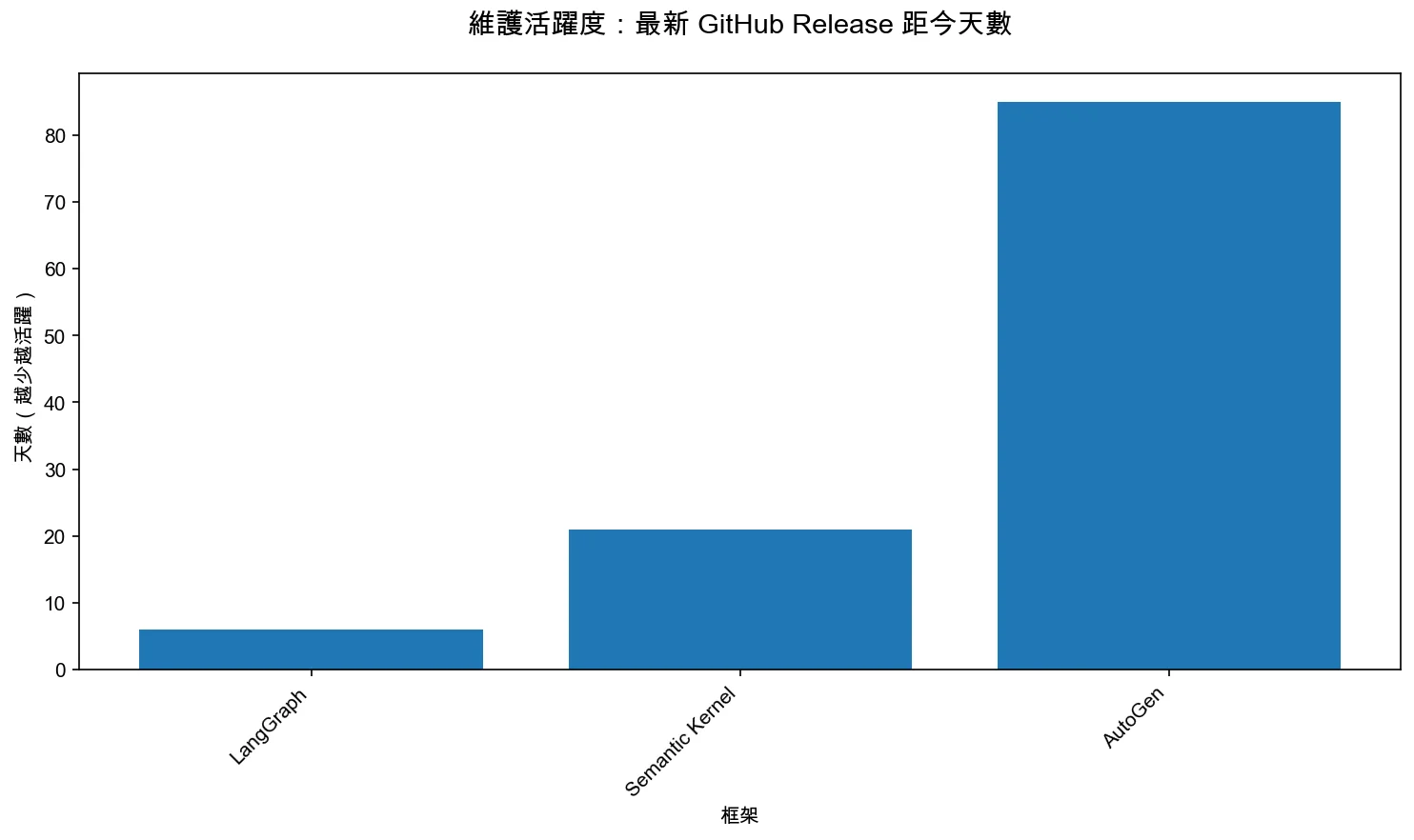

圖表:維護活躍度(避免選到「看起來很紅、但其實沒在動」)

我不會用主觀打分來評比框架成熟度;我只做一個最容易被稽核與工程團隊接受的量化指標:最新 GitHub Release 距今天數(越少代表維護越活躍,通常也代表你踩到 bug 時比較有機會在近期版本看到修正)。

這張圖不會告訴你「誰最好」,但它會提醒你:如果你在金融內控情境要扛責任鏈,維護節奏太慢的框架,通常會把風險轉嫁回你自己的團隊(你得自己 patch、自己維護 fork、自己扛升級成本)。

停損線(Kill Switch)— 你一定要先寫進設計裡的「停止條款」

只要碰到以下任一條,就必須自動降級或停止輸出:

- 資料快照不完整:缺少關鍵檢核輸入(客戶分級、倉位快照、限制表、當下風控參數)。

- 規則/模型/提示版本不明:無法指向某個 immutable 版本(含變更時間與批准人)。

- 無法重放:同一輸入無法在可接受誤差下重現相同檢核結果與理由鏈。

- 延遲/成本超標:造成下單體驗或交易窗口被吃掉(我會建議你先定 SLA;超標就降級成規則引擎直出 + 不出 LLM 說明)。

- 偵測到高風險輸出模式:把不確定說成確定、無引用就下結論、試圖越權建議繞過限制。

低後悔推薦 Set(3 個 item,直接拿去選)

你提供的候選是:

CrewAI / AutoGen (Microsoft) / LangGraph / OpenAI Swarm / MetaGPT / Microsoft Semantic Kernel / Phidata / CAMEL

我會把「能當生產主幹」跟「只能當試點/對照」分開。先給你主幹 Set:3 個 item,足夠你在一週內做出架構決定。

Set item 1:LangGraph(把流程變成第一級資產)

- Verdict:主幹優先(偏 Python/工作流導向)

- Fits:

- 你要把下單前檢核寫成「可視化的流程節點 + 分支」,而不是一段 prompt

- 你需要長流程、多步驟的狀態管理,方便稽核與重放

- 你要把 deterministic 檢核與 LLM 解釋層拆乾淨

- Avoid:

- 你只想「更好寫 prompt」;流程依舊塞在文字裡(那你只是把不可稽核包裝成圖)

- Regret risks(你會後悔的方式):

- 你先把整個檢核流程丟給 agent「自己想」,結果每次跑出來的理由鏈都不一致,稽核只能當抽樣。

- Link(可核對來源):

- LangGraph(GitHub)(訪問日期:2025-12-24)

- 影片核對(可追溯引用):

- 我用一支入門整理影片,核對「LangGraph 是偏 graph-based、stateful workflow、適合複雜 agent」這個定位(引用:

LangChain vs LangGraph vs LangSmith,9:25–10:05)。

Set item 2:Microsoft Semantic Kernel(把企業治理接入點先站穩)

- Verdict:主幹可選(偏企業整合 / agent 架構與模式)

- Fits:

- 你需要把 agent 的身分、行為、互動模式(以及工具/設定)做成一致的工程抽象

- 你希望在 .NET / 企業內既有系統裡比較自然地落地與交接

- 你想先把「誰能做什麼」的治理面釘死,再談多代理分工

- Avoid:

- 你以為選了它就「自動合規」(合規不是框架功能,是你要寫進流程契約的工程)

- Regret risks:

- 你沒先定義 audit bundle 與版本策略,只把 agent 組起來跑,最後稽核缺欄位只能重做。

- Link:

- Semantic Kernel(GitHub)(訪問日期:2025-12-24)

- 影片核對(可追溯引用):

- Microsoft Developer 的節目裡,來賓用一句話把 SK 定位講得很直白:它是「open source、model agnostic SDK,用來 orchestrate robust AI agents 與 multi-agent workflows」(引用:

Building AI Agent Workflows with Semantic Kernel,0:02–1:13)。

Set item 3:Microsoft AutoGen(把多代理對話變成可插拔的工程系統)

- Verdict:主幹可選(偏多代理互動與 middleware 擴充)

- Fits:

- 你需要多代理協作,但不想把所有擴充寫死在每個 agent 裡

- 你想用 middleware 把「記錄、轉換、控權、攔截」做成可重用能力

- 你希望跟 Semantic Kernel 生態做更緊的組合(例如整合套件)

- Avoid:

- 你把它拿來做「讓 agent 自己決定要不要放行下單」(你會被內控打爆)

- Regret risks:

- 你沒有把 deterministic 檢核放在前面,讓多代理去討論規則本身,最後變成「看起來很聰明,但無法保證一致」。

- Link:

- AutoGen(GitHub)(訪問日期:2025-12-24)

- 影片核對(可追溯引用):

- Microsoft Developer 談 Foundry 的 multi-agent orchestration 時,開場直接把「Microsoft Agent Framework / Semantic Kernel / Autogen」放在同一組能力範圍裡(引用:

AI powered automation & multi-agent orchestration in Foundry,0:12–0:29)。我把它拿來當「企業級落地語境」的核對點:你不是在挑玩具框架,你是在挑能接入企業治理/服務化的那一套。

我另外再補一支更「AutoGen 本體」的權威來源:Microsoft Research 針對 AutoGen v0.4 的設計更新,直接講到「分層架構帶來 flexibility / scalability」與整個 extension 生態(引用:

AutoGen v0.4: Reimagining the foundation of agentic AI for scale and more,0:00–0:50)。

我排除的(What we excluded and why)

我不是說它們「不好」,而是說:在「對外 + 人審 + 內控稽核」這個前提下,把它們當主幹風險太高。

- OpenAI Swarm:我會把它當「概念/實驗對照」,不當生產主幹。原因很簡單:你需要的是可稽核的流程資產,而不是更輕量的 agent 玩法。

- Link:openai/swarm(GitHub)(訪問日期:2025-12-24)

- MetaGPT:它更像是拿來做角色協作與特定工作流探索(例如軟體工程式的分工),不適合直接扛「下單前檢核」這種責任鏈很重的主流程。

- Link:geekan/MetaGPT(GitHub)(訪問日期:2025-12-24)

- CAMEL:我會把它當研究/推理模式的參考,不當生產主幹。原因同樣是:你這裡最怕的是不可回溯與不可重放。

- Link:camel-ai/camel(GitHub)(訪問日期:2025-12-24)

額外提醒:CrewAI / Phidata 我不會在這篇把它們列為「主幹推薦」;它們可以用來做試點,但你必須有把治理殼補起來的決心。

Regret map:三種最常見後悔情境(以及你要怎麼避免)

後悔情境 1:稽核來了,你才發現「你根本重放不了」

我最常看到的災難不是模型 hallucinate,而是你不知道它當時是基於什麼狀態做出那個結論。倉位快照是什麼時間點抓的?限制表是哪一版?那天臨時加的風控參數有沒有套上?批准的人看的是哪一份摘要?

如果你只能回放「對話文字」,你就會被迫把責任推給人:最後變成「當時審核的人沒看清楚」。但這種推法在金融內控裡通常只會讓你更難交代,因為內控要的是流程證據,而不是情緒證詞。

避免方式:把 audit bundle 當成產品;每次檢核都封存輸入快照、規則版本、決策點與批准紀錄。框架只是承載方式,沒有 audit bundle 的框架再強也救不了你。

後悔情境 2:延遲吃掉下單窗口,你只好偷偷把檢核關掉

你可能會想:「多跑幾個 agent 檢核比較安全吧?」但在交易場景,延遲不是 UX 問題,是風險問題:你在某些商品或時段,窗口就是那幾秒。

我看過最常見的變形是:一開始大家很認真,流程跑滿、說明寫得很漂亮;兩週後營運開始抱怨,說「客戶下單卡住」,於是工程團隊只好先把 LLM 解釋層關掉,最後連例外流程也被繞過,系統回到「人腦 + Slack」。

最可怕的是:你以為你在做更嚴謹的風控,結果你做的是一個最後會被自己關掉的系統。

避免方式:先定 SLA,並做出清楚的降級路徑:超時就只跑 deterministic 檢核、只輸出結構化結果;LLM 說明變成可選,而不是必經。

後悔情境 3:例外流程被 prompt 越權,責任鏈瞬間破裂

下單前檢核一定會遇到例外:臨時額度、特殊客戶、特殊商品、或臨時風控參數調整。多代理很容易把「例外」變成一段看起來合理的說明,然後不知不覺越過了該有人批准的環節。

你以為你建立了 Human‑in‑the‑loop,但實際上你只是把「審核」變成一個 UI 上的按鈕;當 agent 的說明很順、很像人講話時,按鈕就會被按得很快。

最後一旦出事,責任會變成:到底是 agent 越權?還是人沒看?還是流程設計根本沒把例外變成「需要額外證據與二次批准」的強制路徑?

避免方式:把例外做成硬流程:例外必須附上明確的證據欄位、二次批准(或多方批准)、並把「例外理由 + 依據」納入 audit bundle。LLM 只能協助整理證據,不得產生「允許例外」的結論。

低後悔起手式(Low-regret starting path)

如果你今天要我給一個最實務的起手式,我會這樣做:

- 先選 1 個主幹框架:在 Python 團隊主導 → 先用 LangGraph;在 Microsoft 生態主導 → 先用 Semantic Kernel / AutoGen。

- 先把 deterministic 檢核跑起來:倉位/額度/黑名單/時段/產品限制全部先規則化;LLM 一開始只做「解釋與引用」。

- 先做 audit bundle:我寧願你先少一個 agent,也不要少一個欄位(因為半年後補欄位,通常要連資料管線、UI、權限、稽核流程一起動,會痛到你想哭)。

- 最後才擴成多代理:等你確定哪些步驟真的需要分工(證據整理、說明、例外流程),再引入多代理,而不是反過來。

(你可能會想:「補稽核到底有多痛?」我講個保守估計:如果你上線時只存對話,後來要補 audit bundle,常見會變成 2–3 個工程師、連續 6–10 週的重構;而且中間還會被法遵/內控反覆打回來。這還不算機會成本。)

Research notes(至少 10 條;訪問日期:2025-12-24)

說明:以下來源頁若未標註更新日期,一律以「訪問日期」作為資料日期標記。

-

LangGraph 將 actors 與 channels 組合為 Pregel 應用,並以多步驟執行組織流程。

- Source:LangGraph docs: Pregel

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

LangGraph Platform 組件包含 Server/CLI/Studio 與 control/data plane 等概念(偏部署/管理面)。

- Source:LangGraph docs: llms.txt

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

LangGraph 提供 supervisor / swarm 等 multi-agent 架構概念(含 handoffs)。

- Source:LangGraph docs: llms.txt

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

Semantic Kernel 對 agent 的核心屬性定義包含 Identity / Behavior / Interaction。

- Source:SK decision: 0032-agents

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

Semantic Kernel 支援 Direct Invocation 與 Agent Chat 兩種互動模式。

- Source:SK decision: 0032-agents

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

AutoGen 文件提到可以為 agent 註冊 middleware(並提供範例與延伸文件)。

- Source:AutoGen: Agent overview

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

AutoGen 提供與 Semantic Kernel 整合的套件(AutoGen.SemanticKernel)與起步說明。

- Source:AutoGen.SemanticKernel Overview

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

Semantic Kernel 的 Agent Framework migration 說明指出 agent 建立可透過不同 provider 的擴充簡化。

- Source:SK AgentFrameworkMigration README

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

OpenAI Swarm(候選但本文排除為生產主幹)官方 repo 可供核對。

- Source:openai/swarm

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

MetaGPT(候選但本文排除為生產主幹)官方 repo 可供核對。

- Source:geekan/MetaGPT

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

CAMEL(候選但本文排除為生產主幹)官方 repo 可供核對。

- Source:camel-ai/camel

- Search Date:2025-12-24;Data Date:來源未標註日期,訪問日期:2025-12-24 -

YouTube:影片用「graph-based stateful workflow」解釋 LangGraph 的定位。

- Product/Service: LangGraph

- Source Type: YouTube Video (Transcribed)

- Source: https://www.youtube.com/watch?v=vJOGC8QJZJQ

- Video Title: LangChain vs LangGraph vs LangSmith

- Video Date: 2025-07-02

- Channel: codebasics

- Transcript Date: 2025-12-24

- Key Facts from Transcript:- 影片將 LLM 應用分為 workflows vs agents,並指出 LangGraph 更偏「用 graph 結構編排 stateful workflow」來支援複雜 agent。

- 影片提到 graph-based 的流程可以有不同分支、回圈與重試等行為(作為「複雜 agent」的心智模型)。

- Cited Timestamps: 9:25–10:05

- Embed Required: Yes

- Relevance Score: 4

- Usability: Yes(可用來支撐「為什麼 LangGraph 適合把檢核流程顯式化」)

- Why it matters (decision relevance): 這段把 LangGraph 的「流程編排」定位講得夠具體,可用來對照本文的「可稽核流程資產」前提。

- Link Verified: Yes

- Freshness Check: 6 個月內(訪問日期:2025-12-24)

-

YouTube:Microsoft Developer 用一句話定義 Semantic Kernel 的 agent / multi-agent 定位。

- Product/Service: Microsoft Semantic Kernel

- Source Type: YouTube Video (Transcribed)

- Source: https://www.youtube.com/watch?v=3JFKwerYj04

- Video Title: Building AI Agent Workflows with Semantic Kernel

- Video Date: 2025-07-29

- Channel: Microsoft Developer

- Transcript Date: 2025-12-24

- Key Facts from Transcript:- 來賓將 Semantic Kernel 描述為 open source、model agnostic SDK,用來 orchestrate robust AI agents 與 multi-agent workflows。

- 節目示範從 single agent 走到 orchestrate multiple agents(sequential orchestration 的示意)。

- Cited Timestamps: 0:02–1:13

- Embed Required: Yes

- Relevance Score: 5

- Usability: Yes(官方頻道、定位清楚)

- Why it matters (decision relevance): SK 在本文被放在「企業治理接入點」的推薦項;這段是可核對的官方口徑。

- Link Verified: Yes

- Freshness Check: 6 個月內(訪問日期:2025-12-24)

-

YouTube:Microsoft Developer 將 Foundry / Agent Framework 與 Semantic Kernel / AutoGen 並列,用來做 multi-agent orchestration。

- Product/Service: Microsoft Agent Framework / AutoGen / Semantic Kernel(企業落地語境)

- Source Type: YouTube Video (Transcribed)

- Source: https://www.youtube.com/watch?v=v1Q7rEE3StM

- Video Title: AI powered automation & multi-agent orchestration in Foundry

- Video Date: 2025-12-10

- Channel: Microsoft Developer

- Transcript Date: 2025-12-24

- Key Facts from Transcript:- 開場點名 Agent Framework、Semantic Kernel、Autogen 與 Foundry Agent Service,並說明主題是 AI-powered automation 與 multi-agent orchestrations。

- 將上述能力放在「Foundry 的 developer tools and services」語境下,偏向從 prototype 到可部署/可管理的方向延伸。

- Cited Timestamps: 0:12–0:29

- Embed Required: Yes

- Relevance Score: 5

- Usability: Yes(官方頻道、直接點名)

- Why it matters (decision relevance): 本文的核心是「可稽核、可治理、可停損」;這段提供 Microsoft 生態在 enterprise/multi-agent orchestration 的官方語境。

- Link Verified: Yes

- Freshness Check: 30 天內(訪問日期:2025-12-24)

-

YouTube:Microsoft Research 介紹 AutoGen v0.4 的分層架構與擴充生態(偏「可擴展」的官方說法)。

- Product/Service: Microsoft AutoGen

- Source Type: YouTube Video (Transcribed)

- Source: https://www.youtube.com/watch?v=LM6JcqLeF0U

- Video Title: AutoGen v0.4: Reimagining the foundation of agentic AI for scale and more | Microsoft Research Forum

- Video Date: 2025-02-25

- Channel: Microsoft Research

- Transcript Date: 2025-12-24

- Key Facts from Transcript:- 影片開場將 AutoGen 描述為領先的開源 multi-agent framework,並指出 v0.4 是一次「complete redesign」,目標是為 agentic AI 的研究與應用打基礎。

- 影片明確提到 v0.4 的「layered architecture」提供 flexibility 與 scalability,並包含 extensions 與應用的生態(例如 Magentic-One、Studio)。

- Cited Timestamps: 0:00–0:50

- Embed Required: Yes

- Relevance Score: 5

- Usability: Yes(官方頻道、直接談 v0.4 設計目標)

- Why it matters (decision relevance): 本文把 AutoGen 放在「可插拔工程系統」的位置;v0.4 的分層/可擴展定位是能支撐「企業級可維運」的判斷依據之一。

- Link Verified: Yes

- Freshness Check: < 1 年(但非 6 個月內);屬於架構/定位敘述,仍具參考價值。若要核對最新 API/版本差異,請以 GitHub release 與文件為準(訪問日期:2025-12-24)

-

Chart data:三個主推薦框架的最新 GitHub Release 日期(用來生成「距今天數」圖表)。

- Product/Service: LangGraph / Semantic Kernel / AutoGen

- Fact: LangGraph 最新 release 發布於 2025-12-18;Semantic Kernel 最新 release 發布於 2025-12-03;AutoGen 最新 release 發布於 2025-09-30(皆為 GitHub latest release 的 published_at)。

- Why it matters (decision relevance): 在需要扛內控稽核與長期維運的情境,維護節奏太慢常會把 bug/升級成本轉嫁到企業自己身上。

- Source: GitHub REST APIGET /repos/{owner}/{repo}/releases/latest(查詢日期:2025-12-24)- https://api.github.com/repos/langchain-ai/langgraph/releases/latest

- https://api.github.com/repos/microsoft/semantic-kernel/releases/latest

- https://api.github.com/repos/microsoft/autogen/releases/latest

- Search Date: 2025-12-24

- Data Date: 2025-12-18 / 2025-12-03 / 2025-09-30

- Link Verified: Yes

- Freshness Check: 皆為 6 個月內(訪問日期:2025-12-24)

FAQ(可被搜尋的問題;本篇為 Set,不做 FAQ Schema)

註:FAQ 的「結構化資料(JSON-LD)」通常需要由網站模板在

<head>輸出。本篇是 Set,所以這裡只提供讀者會用來搜尋的問答,不另外加 schema。

Q1:證券下單前檢核用 multi-agent,最容易後悔的是什麼?

A:不是「模型答錯」,而是你回放不了:當時用的是哪個倉位快照、哪一版限制表、哪一版規則、誰批准。你如果只存對話,最後會把責任推回人類審核者,這在內控稽核裡通常更難交代。

Q2:LangGraph / Semantic Kernel / AutoGen,我應該先選哪個?

A:先看你要解哪種風險。

- 你要把流程變成第一級資產(節點/分支/狀態/重放)→ LangGraph

- 你要把企業治理接入點先站穩(平台/身份/交付/模式)→ Semantic Kernel

- 你要多代理互動、擴充、攔截變成工程能力(例如 middleware 思維)→ AutoGen(通常跟 SK 一起看更順)

Q3:我可以用 AutoGen 做「自動放行下單」嗎?

A:不建議,也不符合本文前提。你可以用 AutoGen(或任何框架)做「檢核建議 + 證據整理 + 可追溯說明」,但放行下單要有人類審核,例外要有硬流程與二次批准,並被封進 audit bundle。

Q4:Swarm / MetaGPT / CAMEL 為什麼不當主幹?

A:因為你現在缺的不是「更多代理玩法」,而是能把責任鏈與證據鏈釘死的工程與治理。這三個可以當對照或研究參考,但在「對外 + 人審 + 內控」前提下不適合作主幹。